SoftMax指北

SoftMax指北

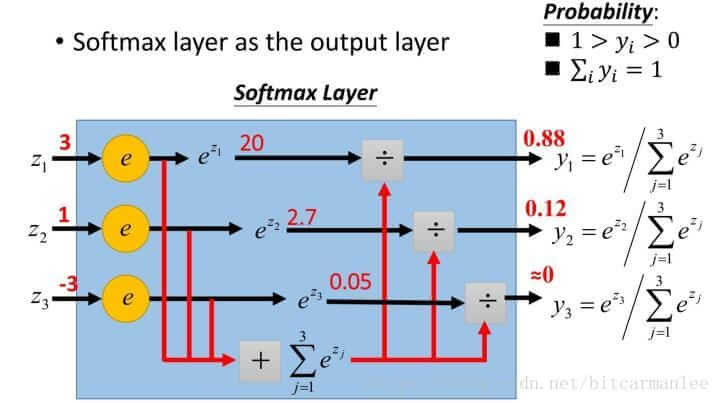

softmax函数,又称归一化指数函数。是将多分类的结果用概率的形式表示出来,而各种预测结果概率和为1,下图为SoftMax的计算方法。

e的zi次方保证了结果非负,除以总和保证了总和为1,这样就可以得出近似的概率。

代码示例

这边选用Fashion-Mnist作为示例.

第一步下载数据集

1 | train_data = torchvision.datasets.FashionMNIST("./data/mnist",train=True,download=True) |

第二步设置各种函数

简单设置了一个线性层,输入维度784,输出维度10

损失函数使用交叉熵

优化器用随机梯度下降法

1 | net = nn.Sequential(nn.Linear(784,10)) |